Google und Facebook manipulieren Meinungen. Laut Studien können sie sogar Wahlen entscheiden. Und auch zum Brexit könnten sie beigetragen haben.

Beeinflussung der Meinungsbildung: Verschiedenen Nutzern werden online verschiedene Inhalte angezeigt.

Bild: Keystone/Montage: scitec

Auf den ersten Blick mag das Anliegen der Facebook-Mitarbeiter grössenwahnsinnig erscheinen: «Welche Verantwortung hat Facebook, um Donald Trump 2017 zu verhindern?», fragten sie ihren Chef im März. Jede Woche stimmen die Mitarbeiter ab, was sie von Zuckerberg wissen wollen. Ganz offenbar werden sie sich der Macht ihres Konzerns immer bewusster – und ein entscheidender Teil der Facebook-Beschäftigten denkt darüber nach, diese Macht für Manipulationen zu nutzen. Verschiedene Studien zeigten, dass Facebook in der Tat Wahlen beeinflussen kann – und Experten befürchten, dass die US-Präsidentschaftswahl eine der ersten sein könnte, in der das in grossem Stil geschieht.

Subtile Beeinflussung

Mehr als 30 Prozent der US-Amerikaner informieren sich laut der amerikanischen Soziologin Zeynep Tufekci ausschliesslich via Facebook über aktuelle Nachrichten. Und auch in Europa steigt die Zahl der Menschen, für die Social Media klassische Medien ersetzen. Darum warnen Forscher immer stärker vor dem Sortier-Verfahren von Facebook, das jedem Nutzer seine Nachrichten in individueller Reihenfolge präsentiert. Der Konzern selbst hat in mehreren Studien gezeigt: Schon winzige Veränderungen in diesem Algorithmus können die Meinung der Nutzer zu den geteilten Inhalten anderer verändern. Auch die Wahlbeteiligung kann Facebook laut einer eigenen Studie beeinflussen: Während der Kongresswahlen 2010 schickte das Netzwerk 61 Millionen Nutzern eine Nachricht, die sie an die Wahl erinnerte und anzeigte, wie viele ihrer Freunde schon wählen waren.

Jene Nutzer gingen signifikant häufiger wählen als die Kontrollgruppe ohne entsprechende Nachricht. Diese Manipulation kann bei einem knappen Ausgang wahlentscheidend sein, warnt die Soziologin Tufekci: «Facebook kann Wahlen beeinflussen – ohne dass wir das nachweisen können.» Die Beeinflussung sei schliesslich so subtil, dass sie weder für den Einzelnen noch für übergeordnete Stellen wie Gerichte oder Regulierungsbehörden nachvollziehbar ist.

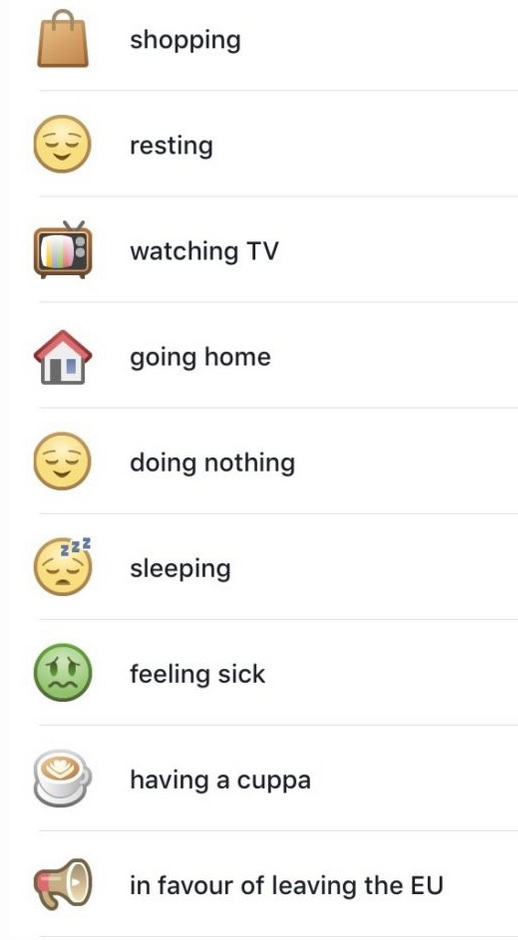

Sogar zum Brexit könnte Facebook beigetragen haben: Der Blogger Jon Worth bemerkte kurz vor der Abstimmung einen Vorschlag seiner Facebook- App, er solle seine Gefühle oder Aktivitäten mitteilen. Zur Auswahl stand neben Freizeitaktivitäten wie «Ich schaue fern» und «Ich trinke Kaffee» auch «Ich bin für einen Austritt aus der EU». Die gegenteilige Option gab es nicht. «Es stellt sich einmal mehr die Frage, wie unabhängig soziale Netzwerke in politischen Fragen sind», kommentiert Worth seine Entdeckung.

Nutzer meist ahnungslos

Facebook ist nicht allein: Auch bei der Suchmaschine Google entscheidet ein Algorithmus im Hintergrund, welcher Nutzer welche Ergebnisse angezeigt bekommt. Studien des Psychologen Robert Epstein aus Cambridge in den USA zeigen, wie eine veränderte Auswahl an Suchergebnissen Wähler eher zugunsten des einen oder des anderen Kandidaten entscheiden liessen. Nachdem Epstein diese Hypothese zunächst in einer Laborstudie testete, nutzte er schliesslich die Wahlen in Indien 2014 für ein Experiment. Dafür rekrutierte er mehr als 2000 noch unentschlossene Wähler und teilte sie in Gruppen ein: Eine Gruppe bekam bei ihrer Internet-Recherche mehr Suchergebnisse über den einen, eine zweite Gruppe mehr über den anderen Kandidaten präsentiert. Die Vorlieben verschoben sich um durchschnittlich 9,5 Prozent jeweils zugunsten des Kandidaten, der in den Suchergebnissen bevorzugt vorkam.

Besonders brisant ist vor diesem Hintergrund, dass nur eine kleine Minderheit der Nutzer von Google und Facebook weiss, dass ihre Ergebnisse individuell und automatisch sortiert werden. Die meisten halten das Suchergebnis schlicht für eine Abbildung der Realität.

Die komplexen Rechenregeln, die Nachrichten und Suchergebnisse in Abhängigkeit vom jeweiligen Leser sortieren, nennt man «Gatekeeper-Algorithmen», da sie entscheiden, welche Inhalte zum Nutzer durchdringen und welche nicht. Damit haben Google und Facebook eine ähnliche Rolle und Verantwortung wie die klassischen analogen «Gatekeepers» – beispielsweise Journalisten, die auswählen, welche Nachrichten sie in ihrer Zeitung bringen. Nur dass in einer Zeitung alle Leser das Gleiche zu sehen bekommen und wissen, dass es eine Auswahl ist. Der Entscheidungsprozess von algorithmischen Gatekeepern hingegen ist für die Nutzer nicht nachvollziehbar – und das macht sie doppelt gefährlich, so Epstein: «Solche unsichtbaren Einflüsse überzeugen nicht nur, sie hinterlassen auch noch das Gefühl, man habe sich eine eigene Meinung gebildet, ohne äussere Beeinflussung.»

Konzerne lehnen Verantwortung ab

Bedenklich ist ein Experiment, mit dem der französische Informatiker Kave Salamatian zeigte, wie sehr der Algorithmus eine Radikalisierung junger Menschen fördert. Der Forscher legte 130 Schein-Profile bei Facebook an und liess studentische Mitarbeiter drei Tage lang verschiedene Nachrichten und Informationen auf Facebook mit «Gefällt mir» markieren. «Wir haben dafür harmlose Themen ausgewählt, die junge Menschen interessieren», erklärt Salamatian: beispielsweise Tierschutz, aktuelle Kinohits oder auch eine Gruppe «I am fat and I hate that» (ich bin dick und hasse das). Nach diesen drei Tagen liess er die Accounts automatisch allen Empfehlungen des Netzwerks folgen – sie akzeptierten jeden neuen Freund und klickten bei jedem Vorschlag auf «Gefällt mir», den der Algorithmus ihnen präsentierte. Das Ergebnis war erstaunlich: Nach weiteren drei Tagen hatten zehn der Profile direkten Kontakt zu Profilen des terroristischen IS, erste Recruiter meldeten sich bei den Schützlingen. Weshalb es zu einer Annäherung radikaler Gruppen kommt, ist nicht klar, da Facebook seinen Algorithmus nicht offenlegt. Eine Rolle mag dabei auch spielen, dass der IS auf sozialen Medien sehr aktiv ist.

Facebook selbst weist ebenso wie Google in solchen Fällen jede Verantwortung von sich. Aufgabe des Algorithmus sei lediglich, jedem Nutzer passende Suchergebnisse in kurzer Zeit zu präsentieren, so die Antwort. Erst auf Nachfrage und unter Wahrung der Anonymität berichtet ein Google-Mitarbeiter, dass bei den grossen US-Unternehmen durchaus eine gewisse Ratlosigkeit herrscht: «Google-Chef Larry Page hat mich gefragt, wie wir unseren Algorithmus so verändern könnten, dass er bessere ethische Entscheidungen trifft. Der Wille ist da, aber die Lösung fehlt.»

Keine Kommentare